人工智能 天使的利刃,还是潘多拉魔盒?——论人工智能应用软件开发的机遇与挑战

人工智能,这个二十一世纪最具颠覆性的技术浪潮,正以前所未有的速度渗透到我们生活的每一个角落。从清晨被智能音箱唤醒,到深夜通过算法推荐的影片放松,从无人驾驶汽车到辅助医生诊断的医疗影像系统,人工智能应用软件(AI Applications)作为技术落地的直接载体,正在重塑世界。伴随着其潜能的无限释放,一个深刻的哲学与技术伦理问题也日益凸显:人工智能究竟是带来福祉的“天使”,还是释放未知风险的“魔鬼”?答案并非非此即彼,关键在于我们——人类——如何进行负责任的开发与应用。

天使之翼:AI应用软件带来的福祉之光

在积极的一面,人工智能应用软件无疑是推动社会进步的强大引擎,扮演着“天使”的角色。

- 效率革命与生产力解放:在工业领域,AI驱动的预测性维护软件能极大减少设备停机时间;在办公场景,智能流程自动化(RPA)软件接管了大量重复性文书工作。这释放了人类的创造力,让我们得以专注于更富战略性和创新性的任务。

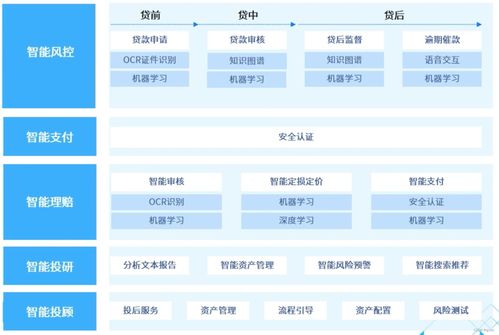

- 精准化与个性化服务:基于机器学习算法的推荐系统(如电商、流媒体平台)提供了前所未有的个性化体验。在医疗健康领域,AI辅助诊断软件能帮助医生更早、更准确地发现病灶(如早期肺癌、糖尿病视网膜病变),拯救无数生命。教育类AI软件则能提供自适应学习路径,因材施教。

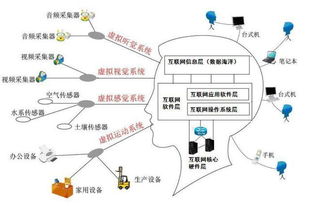

- 解决复杂全球性挑战:AI软件在气候变化建模、新药研发(如通过模拟加速分子筛选)、智慧城市管理(优化交通、能源使用)等方面展现出巨大潜力,为解决人类共同面临的难题提供了新工具。

- 赋能残障人士:视觉识别、语音合成与识别等AI技术,通过软件形式化为听障、视障人士的“眼睛”和“耳朵”,极大地增强了他们的社会参与能力。

这些应用深刻地诠释了技术为善(Tech for Good)的理念,展现了AI作为“天使”的赋能本质。

魔鬼低语:AI应用开发中的潜在风险与暗影

技术本身并无善恶,其影响取决于如何使用。在AI应用软件的开发与部署过程中,若缺乏审慎的伦理考量和有效的规制,“天使”的工具也可能滑向“魔鬼”的深渊。

- 算法偏见与歧视:AI系统的决策依赖于训练数据。如果数据本身反映了社会现有的偏见(如性别、种族歧视),那么AI软件就会将这些偏见自动化、规模化地复现和放大,例如在招聘、信贷审批中产生不公平的结果。

- 隐私侵蚀与数据滥用:许多AI应用的核心是数据。过度收集、使用不当或安全漏洞可能导致用户隐私的大规模泄露。面部识别软件的滥用可能导向监控社会,侵蚀个人自由。

- 责任归属与安全失控:当自动驾驶汽车发生事故,责任在程序员、制造商、车主还是AI本身?随着AI系统日益复杂(尤其是深度学习模型),其决策过程可能成为“黑箱”,难以解释和追溯,导致责任界定困难。关键系统(如电网、金融交易)中的AI一旦出错或遭恶意攻击,后果不堪设想。

- 就业冲击与社会分化:自动化软件在取代部分重复性工作的也可能加剧结构性失业,拉大技能鸿沟,导致社会不平等加剧。

- 深度伪造与信息生态破坏:基于生成式AI的“深度伪造”软件可以轻易制造以假乱真的虚假音视频,用于诽谤、诈骗或扰乱政治进程,严重破坏社会信任和信息安全。

走向负责任的开发:驾驭AI的双重性

因此,将AI简单地定义为“天使”或“魔鬼”是片面的。真正的挑战在于,如何在AI应用软件的开发全生命周期中,建立有效的“护栏”,确保其向善发展。

- 伦理先行,融入设计:开发团队应遵循“可信赖AI”原则,将公平性、可解释性、隐私保护、安全性和问责制等伦理考量嵌入软件设计之初(“伦理设计”),而非事后补救。

- 多元共治,完善规制:需要政府、行业组织、学术界和公众共同参与,建立和完善适应AI发展的法律法规、技术标准与行业准则。例如,欧盟的《人工智能法案》就尝试根据风险等级对AI应用进行分类监管。

- 技术向善,提升透明度:投资发展可解释AI(XAI)技术,使AI决策过程更透明。倡导开发用于公共利益(如环境保护、公共卫生)的AI应用。

- 人才培养与公众教育:培养既懂技术又通伦理的复合型AI开发人才。加强公众的AI素养教育,使社会能更好地理解、监督和利用AI技术。

结论

人工智能应用软件开发,本质上是一场关于人类未来形态的宏大实验。它既握有开启智慧新纪元、破解千年难题的“天使之钥”,也潜藏着解构社会基石、引发未知危机的“魔鬼契约”。其最终走向,不取决于代码本身,而取决于编写代码的人所秉持的价值观、智慧与责任感。我们不应恐惧技术,而应恐惧对技术的滥用和无知。唯有以敬畏之心、审慎之智和坚定之责,在创新与规制之间找到最佳平衡,才能确保人工智能这柄利刃,始终为人类文明的灯塔护航,而非将其斩断。这条路,注定需要开发者、使用者与监管者携手同行。

如若转载,请注明出处:http://www.98186473409.com/product/47.html

更新时间:2026-03-01 20:51:19